ByteDance es una de las compañías tecnológicas que más creció en los últimos años. Se trata de la empresa matriz de TikTok, que es de origen chino, y que reúne a cientos de millones de usuarios. Y, además de la red social, acaba de lanzar OmniHuman1, un nuevo modelo de inteligencia artificial que tiene la capacidad de crear deepfakes de alta verosimilitud.

A través de OmniHuman1, TikTok ingresa a la carrera por la inteligencia artificial, ya que se espera que en algún momento la herramienta se encuentre disponible para los usuarios de la plataforma. Sin embargo, por las capacidades que tiene el sistema y por el daño que pueden generar los deepfakes, todavía no está disponible para todo el público.

En qué consiste OmniHuman1, la flamante IA de ByteDance

El algoritmo presentado por la compañía china tiene la capacidad de replicar gestos, movimientos corporales y hasta la voz de una persona a partir de material de referencia. Esto puede consistir en una sola fotografía y en un solo audio, aunque será más eficiente mientras más contenido multimedia tenga para basarse.

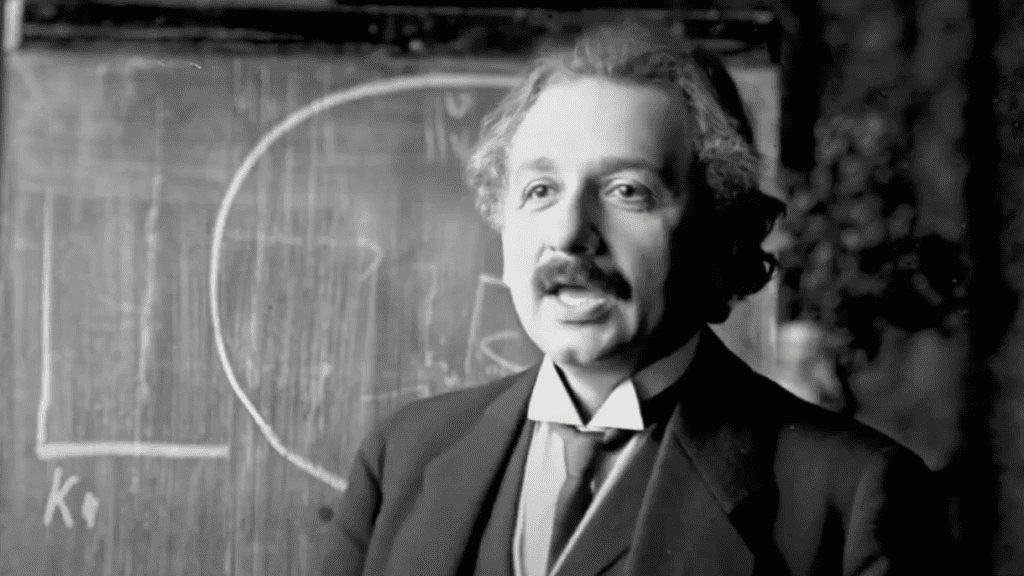

La herramienta de ByteDance se basa en un transformador y en una serie de modelos de difusión que fueron desarrollados para que la imagen tenga un sonido que parezca natural tanto en cómo se expresa la persona como en su modo de hablar. El ejemplo más difundido por las redes sociales consistió en un video de Albert Einstein, que cobraba vida a partir de una foto del científico frente a una pizarra.

Para capacitar al sistema, Bytedance utilizó más de 19 mil horas de video a partir de una técnica que se conoce como entrenamiento mixto de acondicionamiento de movimiento multimodal. Dentro de este programa, se mezclan materiales de distinta calidad y nivel de detalle, lo que luego ayuda a OmniHuman1 a reaccionar de manera eficiente ante la falta de datos.

De esta manera, la inteligencia artificial logra mejorar su rendimiento aún cuando no tiene toda la información que necesitaría para alcanzar un resultado óptimo. De todas maneras, el sistema que fue presentado por ByteDance todavía enseña algunas limitaciones, que se espera que sean corregidas antes de ser lanzadas para el público en general.

“OmniHuman-1 supera significativamente los métodos existentes, generando vídeos humanos extremadamente realistas basados en entradas de señales débiles, especialmente audio. Admite entradas de imágenes de cualquier relación de aspecto, ya sean retratos, imágenes de medio cuerpo o de cuerpo completo, lo que brinda resultados más realistas y de alta calidad en varios escenarios”, explicaron desde Bytedance.

Qué puede realizar OmniHuman1

La capacidad más destacada del sistema es que puede generar vídeos sobre una persona, que tiene la habilidad de gesticular, moverse y hablar solo con una imagen y una pista de audio. Además, es posible completar esta creación en base a cualquier relación de aspecto y proporción corporal. Esto le otorga varias ventajas a los usuarios que utilizan esta tecnología.

Por ejemplo, Albert Einstein puede moverse frente al pizarrón como si fuese un profesor dictando una clase y explicando un concepto. Para que luzca con una gran verosimilitud, OmniHuman1 logra recrear los movimientos naturales de las personas, la iluminación de la escena (en base a la luz que hay en la fotografía) y hasta la textura que tiene la imagen. Todo esto entrega un resultado muy real y creíble para los espectadores.

Por otra parte, además de esto, el sistema de ByteDance es capaz de generar clips basados en videos de referencia para imitar una determinada acción y hasta para cambiar el movimiento de un sector del cuerpo. Sus capacidades no solo se limitan a imágenes de personas, sino que pueden obtener los mismos resultados con dibujos, animales y objetos artificiales.

Por qué el sistema de ByteDance todavía no está disponible

Más allá de que la compañía china presentó sus avances, por el momento la herramienta no se encuentra disponible para el público general. La principal razón se relaciona con que su costo de entrenamiento y de ejecución es bastante elevado. Aunque también hay una preocupación en torno a lo que puede suceder con los deepfakes.

De esta manera, su acceso está limitado a desarrolladores y a estudios de producción que cuentan con una infraestructura avanzada. Esto implica que no exista ninguna versión comercial ni ninguna API pública de OmniHuman1. De hecho, tras el anuncio, los desarrolladores explicaron que cualquier sitio que proporcione un acceso a esta herramienta es un fraude.

De cara al futuro, desde Bytedance esperan desarrollar más modelos de distribución para que los creadores accedan a esta tecnología. Dentro de las posibilidades se encuentran las licencias comerciales o algunas versiones dirigidas a plataformas específicas. TikTok sería la red social en la que se experimentaría con OmniHuman1, aunque para eso faltaría mucho tiempo.

La seguridad y los deepfakes

En este sentido, también habría que esperar a ver qué sucede con la evolución de los deepfakes. Por el momento, dentro de los organismos internacionales y de los gobiernos existe una enorme preocupación por el crecimiento de videos hiperrealistas a partir de imágenes estáticas que tienen el objetivo de manipular los contenidos para engañar a las personas.

Dentro de esta categoría, se teme que se usen los deepfakes para alentar la difusión de información falsa y para suplantar las identidades. Debido a su potencial dentro del ámbito político y privado de las personas, se espera que estas herramientas avanzadas sean reguladas durante este 2025.

Sobre este punto, desde ByteDance explicaron que se encuentran trabajando en estrictas medidas de seguridad y control para evitar que su tecnología, cuando se encuentre disponible para el público, sea utilizada de manera indebida.

El próximo paso de ByteDance será corregir los errores que presenta su herramienta. Esto incluye fallos en movimientos corporales complejos o en la verosimilitud de los detalles más finos. Las equivocaciones más frecuentes se producen cuando las fotografías tienen baja calidad o su iluminación es mala.